12-1. 분석 모델 개요

데이터 분석 방법론 : 통계학에 기반한 통계 모델과 인공지능에서 파생된 기계학습으로 나뉨(그 둘간의 경계는 모호하며 상당부분 겹치기도 함)

→ 기계학습 모델 : 대용량 데이터를 활용해 예측의 정확도를 중요시

→ 통계 모델 : 모형과 해석을 중요시하고 오차와 불확정성을 강조

< 기계 학습 데이터 분석 방법론을 두 가지 기준으로 구분 >

1. 우선 종속변수의 유무 , 지도학습과 비지도학습

2. 독립변수와 종속변수의 속성에 따른 구분, 질적 척도인지 양적 척도인지에 따라 사용할 수 있는 분석 방법론이 다르지만 두가지 방법론이 완전히 구분되는 것은 아님

- 지도학습 : 입력에 대한 정답이 존재하여 출력된 결괏값과 정답 사이의 오차가 줄어들도록 모델을 학습/수정. 결괏값이 질적 척도이면 회귀 방식의 분석론을 사용하고 결괏값이 질적 척도이면 분류 방식의 분석론을 사용함.

- 비지도학습(자율학습) : 별도의 정답 없이 변수 간 패턴을 파악하거나 데이터를 군집화하는 방법.

- 차원 축소 : 지도학습에서 학습 성능을 높이기 위한 전치리 방법으로 주로 사용되는 기법

- 군집 분석 : 서로 유사한 관측치끼리 군집으로 분류하는 기법

- 연관 규칙 : 제품이나 컨텐츠를 추천하기 위해 사용되는 모델로, 각 소비자의 구매 리스트를 통해 제품 간의 연관성을 수치화하여 소비자가 앞으로 구매할 가능성이 높은 제품을 추천할 수 있는 기법

- 강화학습 : 모델의 결과에 보상과 벌을 주면서 스스로 학습하도록 하는 기법. 원숭이에게 바나나가 나오는 A 버튼과 전기 충격이 오는 B 버튼이 있을 때 시행착오를 통해 A 버튼은 좋은 것이고 B 버튼은 나쁜 것이라고 학습하게 되는 것과 유사함.

12-2. 주성분 분석(PCA)

주성분 분석 : 여러개의 독립변수들을 잘 설명해 줄 수 있는 성분을 추출하는 기법. 전체 변수들의 핵심 특성만 추출하기 때문에 독립변수(차원)의 수를 줄일 수 있음. 즉 여러 개의 변수들을 소수의 특정한 변수로 축약하여 변수의 수를 줄이는 기법.

→ 주성분 분석을 통해 모형을 간단하게 만들 수 있고 분석 결과를 효과적으로 해석할 수 있음.

→ 주성분 분석에 사용되는 변수들은 등간척도/비율척도로 측정한 양적변수여야 하며 관측치들은 서로 독립적이고 정규분포를 이루고 있어야 함.

< 차원을 감소시키는 방법 >

- 변수 선택을 통해 불필요하거나 유의성이 낮은 변수를 제거하는 방법

- 변수들의 잠재적인 성분을 추출하여 차원을 줄이는 방법

- PCA (주성분 분석) : 변수의 수를 줄이며 정보의 손실을 최소화할 때 사용

- CFA (공통요인분석) : 변수들 사이에 존재하는 차원을 규명함으로써 변수들 간의 구조를 파악할 때 주로 사용

< PCA >

다차원의 데이터 분포를 가장 잘 설명하는 성분들을 찾아내며, 데이터 공간의 위치하는 점들의 분산을 최대한 보존하는 축을 통해 차원을 축소함. 과정에서는 기존의 변수만큼의 새로운 성분변수가 생성되지만 전체 변수에 대한 설명력이 높은 주성분 변수 일부만으로 대부분의 설명력이 포함되기 때문에 변수의 수를 줄일 수 있음.

다음과 같은 두 변수가 있을 때, 데이터의 분산을 가장 잘 표현할 수 있는 축을 찾기 위해 우선 데이터 표준화를 해주고 직선을 그려 보면 1, 2번 축보다 3번 축이 가장 많은 분산을 담아낼 수 있는 것을 확인할 수 있음.

→ 해당 차원의 가장 많은 분산을 담아내는 축이 주성분이 됨.

주성분을 찾는 과정

- 각각의 포인트에서 축으로 수직이 되도록 선을 그렸을 때, 수직으로 만나는 각 지점들과 (0, 0)의 거리 합이 가장 큰 축을 찾는 것. 그러면 피타고라스 정리에 의해(삼각형에서 대각선인 (0, 0)과 각 포인트 사이의 거리는 일정하므로) 각 포인트와 주성분 축 사이의 거리 합은 최소가 된다. 밑 그래프들은 각각 (위 그래프의) 1, 2, 3번 축과 각 포인트들이 수직으로 만나는 지점들을 축 위에 표시한 것과(3번 축의 분포가 가장 넓게 퍼진 것을 확인할 수 있다) 3번 축에 포인트들과 수직으로 만나는 지점들을 표시한 것임.

가장 설명력이 높은 3번 축과 원점에서 직교하는 축이 두번째 주성분이 됨. 제2주성분은 전체 변수에 대해 설명력이 낮음을 의미하며 3번 축과 대조되는 짧은 길이(낮은 분산)로 생성됨.

→ 변수가 두개(2차원)일 때는 최대 두 개의 주성분을 만들 수 있지만 변수가 n개일 때는(n차원) 최대 n개의 주성분을 만들 수 있음.

주성분의 설명력은 각 주성분의 분산을 의미하며, 모든 포인트들과 주성분 간의 거리 제곱 합을 n-1로 나누어 구함.

→ 밑 그래프에서 x1~x10의 제곱을 모두 더한 뒤 9로 나눈 값

→ 만약 제1주성분의 분산이 15이고 제2주성분의 분산이 5일 때, 제1주성분의 설명력은 전체 분산 20 중 15이므로 75%

< 주성분 분석 실습 >

12-3. 공통요인분석(CFA)

PCA와 CFA는 모두 요인분석을 하기 위한 기법

→ PCA는 전체 분산을 토대로, CFA는 공통분산을 토대로 데이터의 요인을 분석하는 것

요인분석 : 목적에 따라 탐색적 요인분석과 확인적 요인분석으로 구분됨.

- 탐색적 요인분석(EFA) : 변수와 요인 간의 관계가 사전에 정립되지 않았거나 체계화되지 않은 상태에서 변수 간의 관계를 알아볼 때 사용.

- 확인적 요인분석(CFA) : 이미 변수들의 속성을 예상하고 있는 상태에서 실제로 구조가 그러한지 확인하기 위해 사용.

주성분 분석에서는 전체 독립변수들을 잘 설명해줄 수 있는 소수의 주된 성분을 추출.

공통요인분석 또한 전체 독립변수를 축약하지만 상관성이 높은 변수들을 묶은 뒤 잠재된 몇 개의 변수를 찾음.

PCA

- 전체 독립변수들을 잘 설명해줄 수 있는 소수의 주된 성분을 추출.

- 모든 변수들의 총 분산을 기반으로 요인을 추출하기 때문에 전체 변수를 가장 잘 설명해 주는 순으로 주성분의 우위가 결정됨.

CFA

- 공통요인분석 또한 전체 독립변수를 축약하지만 상관성이 높은 변수들을 묶은 뒤 잠재된 몇 개의 변수를 찾음.

- 기본적으로 종류가 다른 변수를 만들어내는 것이 목적이기 때문에 생성된 주성분들 간에 우위 개념이 없음.

- 데이터에서 유사한 성격을 가진 변수들이 많을 때(공통분산을 가진 변수들이 많을 때) 유용하게 사용됨.

<검증 방법> - PCA, CFA 등의 요인분석을 하기 전에 먼저 독립변수 간의 상관성이 요인분석에 적합한지 검증해야 함.

- 바틀렛 (Bartlett) 테스트 : 행렬식을 이용하여 카이제곱값을 구하여 각 변수들 사이의 상관계수의 적합성을 검증하는 방법으로 유의확률 p값으로 나타냄. 이때 p값이 0.05보다 작으면 변수들 간에 상관관계가 있다는 뜻이므로(대각행렬이 아니라는 의미) 분석에 적합하다고 판단할 수 있음.

- KMO(Kaiser-Meyer-Olkin) 검정 : 변수들 간의 상관관계가 다른 변수에 의해 설명되는 정도를 나타내는 방법. KMO 값은 독립변수 간의 상관계수 제곱들과 편상관계수(제 3의 변수를 통제한 상태의 두 변수 간 순수한 상관계수)들을 모두 더한 값에서 상관계수 제곱의 합이 차지하는 비율을 나타내며, 일반적으로 0.8 이상이면 우수, 0.5 이상이면 적합, 0.5 미만이면 부적합으로 봄.

요인분석에서는 그룹별로 요인을 추출하기 때문에 그룹 간의 상관관계가 각각 달라야 요인들이 서로 분리됨.

→ 변수들의 상관관계가 모두 비슷하게 높거나 낮게 나타나면 요인적합에 부적합

적합성을 검증한 뒤, 요인분석을 통해 생성되는 주성분 변수들의 고유치를 통해 요인의 개수를 결정.

- 고유치 : 요인이 설명해 주는 분산의 양을 뜻하며 요인에 해당하는 변수들의 요인 적재 값의 제곱 합 값들을 합하여 구함. → 고유치가 1이라는 것은 해당 요인이 변수 하나만큼의 분산을 가진다는 것을 의미하며 일반적으로 설명력이 높은 요인부터 누적된 설명력이 총 분산의 60% 이상이 되는 요인까지를 선정.

스크리 도표를 참고하여 적당한 요인 수를 구할 수 있음.

- 스크리 도표 : 요인 수에 따른 고유치 변화를 그래프로 나타낸 것으로, 그래프의 경사가 낮아지는 지점(엘보우 포인트)을 통해 요인 수를 선택

요인 적재 값을 통해 각 변수와 요인 간의 상관관계 정도를 확인할 수 있음. 요인 적재 값이+(-) 0.3 이상이면 변수와 요인에 유의성이 있다고 할 수 있으며 +(-) 0.5 이상이면 해당 요인에서 중요한 변수로 판단.

→ 곧 각 요인이 어떤 변수들의 속성을 가지고 있는지를 나타냄. 밑 도표에서 각 변수에 대한 요인 적재 값 예시를 볼 수 있다. 제1주성분(F1)의 경우에는 담배, 술, 커피 소비량에 높은 요인 적재 값을 가지고 있으므로 기호식품 소비량을 의미하는 요인이라고 해석할 수 있다.

12-4. 분석 모델 개요

다중공선성은 독립변수들 간의 상관관계가 높은 현상을 의미한다. 두개 이상의 독립변수가 서로 선형적인 관계를 가지는 현상이며 이는 독립변수들 간에는 서로 독립이라는 회귀분석의 전제 가정을 위반하게 된다. 회귀분석에서 다중공선성이 발생하게 되면 추정치의 통계적 유의성이 낮아져 모델의 정합성이 맞지 않는 문제가 발생한다. 즉 회귀모델은 첫번째 독립변수가 종속변수를 예측하고 두번째 독립변수가 남은 변량을 예측하는 식으로 구성되는데 두 변수가 설명할 수 있는 부분이 거의 동일해지면서 두번째 변수가 설명할 수 있는 변량이 거의 없게 되는 것이다. 이렇게 되면 회귀계수의 분산이 과도하게 증가(독립변수들 간의 상관관계가 증가하면서 각 독립변수의 분산이 회귀모델에 큰 영향을 주기 때문)하고 회귀계수 추정치의 해석이 어려워진다(회귀계수는 뒤에서 다뤄진다).

→ 다중공선성은 여러 기준으로 판별할 수 있다. 우선 회귀 분석 모델을 실행하기 전에 상관분석을 통해 독립변수 간의 상관성을 확인할 수 있다. 상관계수의 절대치가 0.7 이상일 경우 두 변수 간의 상관성이 매우 높고, 다중공선성이 나타날 것을 의심할 수 있다. 하지만 변수의 수가 많을 때는 모든 상관관계를 파악하기가 어려워진다.

→ 다음으로는 회귀분석 결과에서 결정계수(독립변수들의 설명력) R^2값은 크지만 회귀계수에 대한 t값(독립변수와 종속변수 간에 선형관계가 얼마나 강한지를 나타낸다)이 낮을 때 다중공선성을 의심해 볼 수 있다. t값은 표준오차 대비 시그널(해당 변수가 종속변수를 설명하는 정도)을 의미하기 때문에 위 상황은 종속변수에 대한 독립변수의 설명력은 높지만 각 계수 추정치의 표준오차가 크다는 의미를 가진다. 밑 표는 유의확률 수준에 따라 적절한 t값을 나타낸다(유의확률 0.05 수준은 신뢰도 95%의 의미이며 해당 수준에서 t값 기준이 1.96인 이유는 표준정규분표에서 표준편차가 1.96일 때 유의수준이 0.05가 되기 때문이다).

→ VIF(분산팽창계수)를 통해서도 다중공신성을 판단할 수 있다. 각 변수의 VIF 값은 회귀 모델에 사용된 다른 독립변수들이 해당 변수 대신 모델을 설명해 줄 수 있는 정도를 나타낸다. 즉 VIF 값이 크다는 것은 해당 변수가 다른 변수들에 의해 설명될 수 있다는 의미이며 해당 변수가 다른 변수들과 상관성이 높다는 것을 의미한다. VIF 값을 구하는 수식은 다음과 같다.

→ 해당 수식은 K번째 변수의 VIF 값으로, 1에서 K번째 변수에 대한 다른 변수들의 설명력(R^2)을 뺀 값이 분모를 이루고 있다. R^2은 0~1 사이의 값을 가지기 때문에 VIF값은 1부터 무한대의 범위를 갖게 된다. 일반적으로 5 이상이면 다중공선성을 의심하며 10 이상일 경우에는 다중공선성이 있다고 판단한다. 또한 VIF값에 루트를 씌운 값 X는 해당 변수가 다른 변수들과의 상관성이 없는 경우보다(다중공선성이 없는 경우보다) 표준오차가 X배 높다는 것을 의미한다. 표준오차가 높은 변수는 분석 모델의 성능을 저하시키기 때문에 제거하는 것이 좋다.

→ 다중공선성을 해결하기 위한 방법으로는 우선 VIF값이 높은 변수들 중에서 종속변수와의 상관성(설명력)이 가장 낮은 변수를 제거하고 다시 VIF값을 확인하는 작업을 반복하는 것이다. 하지만 특정 변수가 제거 대상이 되더라도 비즈니스적으로 중요한 역할을 할 수 있기 때문에 가설과 비즈니스적 요소도 함께 고려하여 변수를 제거해야 한다.

→ 다른 방법으로는 표본 관측치를 추가적으로 확보하여 다중공선성을 완화시킬 수 있다. 분석 모수(모집단의 특성)가 많아질수록 회귀계수의 분산과 표준오차는 일반적으로 감소하기 때문이다. 하지만 관측치를 추가로 확보하는 것이 현실적으로 불가능한 경우가 많다.

→ 혹은 해당 변수값에 로그를 취하거나, 표준화 및 정규화 스케일링을 해주어 다른 변수와의 상관성을 줄일 수도 있다. 연속형 변수를 구간화하거나 명목변수로 변환하는 것도 가능하며 정보의 손실이 발생할 수도 있지만 변수를 제거하는 것보다는 나을 수 있다.

→ 주성분 분석으로도 다중공선성을 해결할 수 있다. 주성분 분석은 유사한 변수들을 하나의 변수로 합쳐낸 효과가 있기 때문이다. 하지만 주성분 분석을 이용하면 변수의 해석이 어려워진다는 단점이 있다.

→ 마지막으로는 데이터 분석 환경에서 제공하는 변수 선택 알고리즘을 활용하는 방법이 있다. 주로 전진 선택법, 후진 제거법, 단계적 선택법 중 하나를 선택해 특정 기준에 따라 모형에 적합한 변수를 자동으로 선정한다. 다중공선성 문제 해결을 위한 방법들을 정리하면 다음과 같다.

→ 다음으로는 각 독립변수가 종속변수의 설명력에 기여하는 순수한 수치를 계산하는 방법인 섀플리 밸류 분석에 대해 알아보겠다. 우선 다음과 같은 설명력 조합이 있다고 가정한다.

→ x1 변수의 경우, 단일 변수로 투입되었을 때는 0.15의 설명력을 가진다. 그리고 x1과 x2 조합에서 x1의 기여도는 함께 투입되었을 때의 설명력(0.32)에서 x2 단일로 투입되었을 때의 설명력(0.21)을 뺀 값인 0.11이다. 동일한 방법으로 x1과 x3 조합에서 x1의 기여도는 0.29 - 0.17 = 0.04이다. 그러므로 두 변수 조합인 경우에 x1의 기여도는 0.11과 0.04의 평균인 0.115이며 세 변수 조합에서 x1의 기여도는 0.35 - 0.31 = 0.04이다(x2와 x3 조합의 설명력을 빼주었다). 그렇게 구해진 세 값 0.15, 0.115, 0.04를 평균하면 0.101이며 해당 값이 x1의 섀플리 밸류가 된다. 과정을 정리하면 다음과 같다.

→ 동일한 방법으로 계산하면 x2와 x3의 섀플리 밸류는 각각 0.141, 0.106으로 구해진다. 변수 각각의 섀플리 값을 더하면 0.35이며, 세 변수 모두를 투입했을 때의 설명력과 동일함을 확인할 수 있다. 이처럼 섀플리 밸류를 사용해 해당 변수를 모델에 투입했을 때 설명력에 어느정도 기여를 하진지 측정할 수 있다.

12-5. 데이터 마사지와 블라인드 분석

데이터 마사지란 데이터 분석 결과가 예상/의도한 방향과 다를 때 데이터의 배열을 수정하거나 관점을 바꾸는 등 데이터의 해석이 달라질 수 있도록 유도하는 것이다. 비록 데이터의 수치 자체를 바꾸는 것은 아니지만 분석가의 주관이 개입되기 때문에 지양하는 것이 좋다. 데이터 마사지 방법들은 다음과 같다.

- 편향된 데이터 전처리

→ 의도하는 방향에 유리하도록 이상치, 결측값 등을 전처리하는 방식이다. 예를 들어 A그룹과 B그룹의 수치 차이를 원하는 방향으로 유도할 때 A그룹의 수치가 커지도록 유도할 수 있다. A그룹의 값이 큰 이상치에 대해 이상치 처리를 하지 않거나 이상치 선정 기준을 높이는 등의 방법을 사용하는 것이다.

- 매직 그래프 사용

→ 그래프의 레이블 간격이나 비율을 왜곡하여 수치의 차이를 실제보다 크거나 작게 인식하도록 유도하는 방법이다.

→ 위 그래프들처럼 레이블의 간격을 일정하지 않게 하여 그룹 간 차이가 작아 보이게 하거나 최솟값을 83으로 하여 수치 차이를 과장하고, 실제 비율과 다르게 도넛차트를 그려 A 법안에 대한 부정적 인식을 유도할 수 있다(물론 옳지 못한 사례들이다).

- 분모 바꾸기 등 관점 변환

→ 위스키를 예로 들었을 때, 숙성 기간 동안 약 58%의 양이 증발되어 사라지는데 이때 비율의 분모를 처음 원액에서 최종적으로 술병에 담은 양으로 바꾸면 138%가 증발되었다고 할 수 있게 된다.

- 의도적인 데이터 누락 및 가공

→ 일부 데이터를 누락시켜 데이터를 의도한 방향으로 나타내거나 다른 수치와 결합하여 특성을 완화시킬 수 있다. 다음과 같은 원본 데이터에서 3년 단위로 추출해 상승 추세를 나타낼 수도 있고 범위별 평균값을 구해 하락 추세를 나타낼 수도 있다

- 머신러닝 모델의 파라미터 값 변경 및 연산반복

→ 머신러닝 모델에서는 수많은 데이터와 변수를 사용하기 때문에 데이터의 성향을 어느정도 조절할 수 있으며 모델의 파라미터 값을 변경해 가며 원하는 결과를 유도해 낼 수도 있다.

- 심슨의 역설

→ 데이터의 세부 비중에 따라 전체 대표 확률이 왜곡되는 현상을 이용하여 실제와는 정반대로 통계 수치를 표현할 수 있다.

<블라인드 분석>

블라인드 분석은 데이터 마사지에 의한 데이터 왜곡을 방지하기 위한 방법이다. 데이터 분석 과정에서는 의도치 않게(혹은 의도적으로) 기존에 가설과 경험에 의한 선입견이 개입되는 경우가 많다. 이를 인지적 편향 혹은 확증 편향이라 하며 블라인드 분석은 이러한 편향에 의한 오류를 최소화하기 위한 방법이다.

→ 하지만 블라인드 분석이 편향을 완벽하게 방지하는 것은 아니며 이는 분석가의 부정행위를 막기 위한 것도 아니다. 대신 기존에 분석가가 중요하다고 생각했던 변수가 큰 의미가 없는 것으로 결과가 나왔을 때 무리해서 의미부여를 하거나 그 변수에 집착해 해석에 유리하도록 변수를 가공하게 되는 실수를 방지하기 위한 목적이 크다고 할 수 있다.

→ 블라인드 분석에서는 종속변수 Y에 영향을 주는 독립변수들의 명칭과 의미를 모두 감추고 분석 모델을 수행한 뒤 그 결과치만으로 의미를 해석한다. 이를 통해 분석가의 기존 상식에 의한 주관적 해석을 방지할 수 있다.

12-6. Z - test와 T - test

→ Z - test와 T - test, 그리고 (다음 절의) ANOVA는 통계 기반 데이터 분석의 방법론 중 일부이며 집단 내 혹은 집단 간의 평균값 차이가 통계적으로 유의미한지 알아내는 방법이다. Z - test와 T - test는 두 집단 간의 평균 차이를 분석할 때 사용되고 ANOVA는 두 집단 이상일 때에 사용된다.

→ Z - test와 T - test는 단일 표본 집단의 평균 변화를 분석하거나 두 집단의 평균값, 비율 차이를 분석할 때 사용된다. 이 둘을 사용하기 위해서는 분석하고자 하는 변수가 양적 변수이며, 정규 분포이고 등분산이어야 한다. 이 두 분석 방법을 선택하는 기준은 모집단의 분산을 알 수 있는지의 여부와 표본의 크기에 따라 달라진다. 우선 Z - test는 모집단의 분산을 알 수 있는 경우에 사용된다. 하지만 모집단의 분산을 알 수 있는 경우는 거의 없고 대신 표본의 크기가 30 이상인 경우에 (이때는 중심극한정리에 의해 정규분포를 따른다고 볼 수 있으므로) Z - test 사용이 가능하다(이러한 경우에는 Z - test와 T - test의 결과가 유사하게 나타난다).

→ 반대로 T - test는 표본의 크기가 30 미만이어서 표본 집단의 정규분포를 가정할 수 없을 때 사용된다. 하지만 표본 집단의 크기가 30 이상일 때에도 사용 가능하기 때문에 일반적으로 T - test를 사용한다.

→ Z - test와 T - test, ANOVA 도표로 비교하면 다음과 같다.

→ T - test 예시로 A 쇼핑몰에서 기존 고객집단 C(100명)의 월평균 매출이 42,000원이었는데 새로운 마케팅 프로그램을 적용한 이후 월평균 매출이 43,000으로 증가했다. 이때 1,000원의 증가가 통계적으로 유의미한지 분석해 보겠다. 우선 통계적으로 매출 차이가 있는가를 귀무가설(효과/차이가 없다고 가정하는 것)과 대립가설(효과/차이가 있다고 가정하는 것)로 설정했다.

- 귀무가설(H0) : 고객집단 C의 마케팅 프로그램 적용 전후의 월평균 매출은 동일하다

- 대립가설(H1) : 고객집단 C의 마케팅 프로그램 적용 전후의 월평균 매출은 차이가 있다.

다음으로는 적절한 검정 방법을 선택한다. 매출 평균이 단순히 같지 않은지를 검정할 때는 양측검정, 매출 평균이 더 적은가를 검정할 때는 왼쪽꼬리검정, 매출 평균이 더 큰가를 검정할 때는 오른꼬리검정을 선택한다. 위 경우에는 동일한가의 여부를 검정하는 것이기 때문에 양측검정을 선택한다. 다음 그래프들은 각각의 검정 방법을 나타낸 것이다.

→ 유의수준을 일반적인 기준인 0.05로 설정했을 때, 양쪽을 검정하는 것이기 때문에 유의수준도 각각 0.025로 나누어 계산한다. 따라서 p값이 0.025를 초과하는지 여부에 따라 귀무가설의 기각 여부를 결정하게 된다. 즉 p값이 0.025보다 작다면 귀무가설을 기각하여, 월평균 매출이 통계적으로 다르다고 결론 내릴 수 있다.

→ 다음으로는 비교할 평균과 표준편차, 표준오차를 계산한다. 예시에서는 밑 도표와 같다고 하겠다. 이때 월평균 매출이 1,000원 증가하는 것에 대한 각 고객들의 표준편차는 6,250원이며 이를 전체 대상 고객인 100명에 루트를 취한 값인 10으로 나누면 표준오차는 625가 된다.

→ 수식을 해석해 보면 평균의 차이가 클수록, 표본의 수가 클수록 t값은 증가한다. 대신 관측치들의 값 간의 표준편차가 크면 t값은 감소한다. 즉 각 고객들의 마케팅 프로그램 적용 전후 매출 차이가 들쑥날쑥하면 매출 평균의 차이가 우연에 의한 것일 확률이 높기 때문에 귀무가설을 채택하게 되는 것이다.

→ 위의 공식에 수치들을 대입하면 1.6이라는 결괏값이 나온다. 이때 t값이 임계치 2.003보다는 작으며 양측검정의 기각역 경계인 +(-) 1.984에 미치지 못하기 때문에 대립가설을 기각하고 귀무가설을 채택하게 된다. 즉 해당 마케팅 프로그램의 매출 증대 효과는 유의수준 0.05에서 없다고 판단할 수 있다.

→ Z - test도 이와 유사한 방식으로 진행된다. 하지만 Z - test에서는 모집단의 분산을 알고 있기 때문에 집단 값 차이의 표준편차 대신 모집단의 표준편차를 사용한다. 나머지는 동일하다.

→ 다음으로는 T - test에서 두 집단의 평균 차이를 통계적으로 검정하는 방법에 대해 알아보겠다. 우선 본격적인 분석 이전에 두 집단의 값을 산포도로 시각화하여 분포를 확인한다.

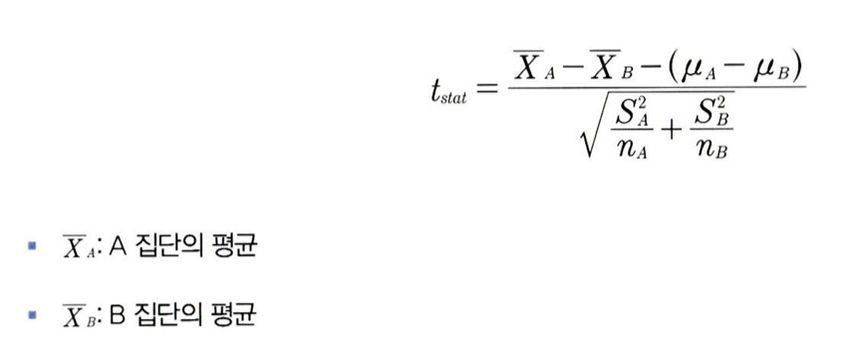

→ 이번에도 동일하게 가설을 설정하고 각 집단의 평균, 분산, 두 집단의 표준평균 차이, 표준오차 등의 값을 통해 t값을 구한다.’

→ 이때 귀무가설은 ‘집단 A와 B의 평균은 차이가 없다’이기 때문에 두 집단 간의 평균 차이를 표준오차로 나누어 t값을 구하게 된다. 표준오차가 크면 두 집단의 평균 차이에 대한 유의도가 감소하며 귀무가설 자체가 두 모집단의 평균은 동일하다고 추정하기 때문에 분자는 사실상 A집단과 B집단의 평균 차이가 된다.

→ 이어서 T - test를 통해 단일 집단의 비율 차이와 두 집단의 비율 차이를 검정해보겠다. 비율의 차이 또한 평균 비교 방식과 유사하다. 비율의 차이를 표준오차로 나누어 t값을 계산한 뒤 유의수준으로 판단하여 대립가설 채택 여부를 판단한다

→ 비율의 분산을 구하는 방법에 대해서만 짚고 넘어가겠다. 표본의 비율을 p로 표현하고 비율의 분산은 p(1 - p)로 계산한다. 표준오차는 비율의 분산을 표본의 수(n)로 나누고 루트를 취해 구한다. 정리하면 다음과 같다.

→ 나머지 공식들은 다음과 같다.

- 단일 집단 비율 차이에 대한 T - test

- 두 집단 비율 차이에 대한 T - test

12-7. ANOVA

→ 세 집단 이상의 평균을 검정할 때에는 ANOVA를 사용한다. T 분포를 사용하는 T - test와 달리 ANOVA는 F 분포를 사용하며 F 검정의 통곗값은 집단 간 분산의 비율을 나타내게 된다(그래서 분산분석이라고도 불린다).

→ ANOVA에서는 회귀분석과 유사하게 F 분포를 통해 독립변수가 종속변수에 미치는 영향을 분석한다. 즉 집단의 종류(독립변수)가 평균 값의 차이 여부(종속변수)에 미치는 영향을 검정하는 것이다.

→ ANOVA의 일반적인 가설은 다음과 같다.

- 귀무가설(H0) : 독립변수(인자)의 차이에 따른 종속변수(특성값)는 동일하다

- 대립가설(H1) : 독립변수(인자)의 차이에 따른 종속변수(특성값)는 동일하다

→ ANOVA는 독립변수인 요인의 수에 따라 다르게 불린다. 요인이 ‘지역’ 하나라면 일원 분산분석으로 불리며 요인이 ‘지역’, ‘연령대’ 처럼 두 가지라면 이원 분산분석, 요인이 N가지라면 N원 분산분석으로 불린다. 또한 ANOVA에서 독립변수는 집단을 나타낼 수 있는 범주(분류)형 변수이어야 하며 종속변수는 연속형 변수이어야 한다.

→ ANOVA는 각 집단의 평균값 차이가 통계적으로 유의한지 검증한다. 이때 집단 내의 각 관측치들이 집단 평균으로부터 얼마나 퍼져 있는지를 나타내는 집단 내 분산과 전체 집단의 통합 평균과 각 집단의 평균값이 얼마나 퍼져 있는지를 나타내는 집단 간 평균의 분산이 사용된다. 이 둘을 그래프로 표현하면 다음과 같다.

→ 이때 각 집단의 평균이 서로 멀리 떨어져 있으면 집단 간 평균 차이가 확실히 난다고 할 수 있지만 각 집단의 분산이 커서 집단 간에 관측치의 값이 겹치는 부분이 크면 각 집단의 평균이 다르다고 보기는 어렵다. 따라서 ANOVA에서는 집단 간 평균의 분산을 집단 내 분산으로 나눈 값이 유의도 임계치를 초과하는지 여부를 검정한다.

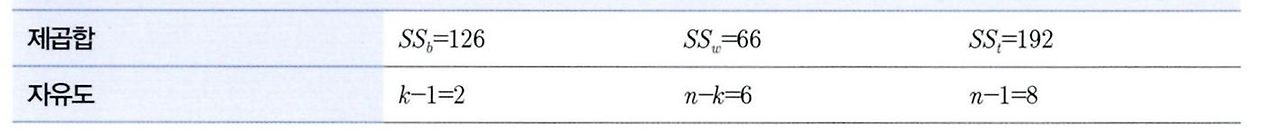

→ 이를 조금 더 이해하기 편하도록 ANOVA 공식 표 형태로 나타내기도 한다. 이때 SSt는 각 관측치에서 전체 평균을 뺀 값의 제곱 합으로, SSb와 SSw를 합한 것과 같기 때문에 SSb와 SSw가 제대로 구해졌는지 확인할 때 사용되기도 한다.

→ 예시를 들어 보겠다. 다음 표는 연령대별로 하루동안 SNS 앱을 실행시키는 횟수이다.

→ 세 집단 평균 차이에 대한 F값은 5.73이다. 이는 F값 임계치인 5.14보다 크기 때문에 집단 간 평균에는 통계적으로 유의미한 차이가 있다고 결론내릴 수 있다. 하지만 세 집단의 평균 중 일부만 다른 것일 가능성도 존재한다. 즉 분산분석 결과로는 집단 간 차이가 있다고 나왔으나 실제로 30대와 40대 간에는 차이가 없을 수도 있다. 이러한 1종오류를 방지하기 위해 사후 검증을 시행한다.

→ 사후검증은 독립변수 수준 사이에서 평균의 차이를 알고자 할 때 쓰이는 기법이다. 각 집단의 수가 같을 때 사용하는 Turkey의 HSD 검증, 집단의 수가 다를 때 사용하는 Scheffe 검증 등이 존재하며 이를 통해 유의수준 안의 부집단을 구별한다. 동일한 부집단에 속한 연령대 집단은 평균의 통계적 차이가 없다고 할 수 있으며 다른 부집단 간에는 유의미한 차이가 있다고 할 수 있다.

12-8. 카이제곱 검정(교차분석)

→ 등간/비율 척도로 이루어진 연속형 변수 간의 연관성을 측정하는 분석 방법으로는 앞에서 공분산과 상관성 분석을 다루었다. 이때 명목/서열척도 등의 범주형 변수들 간의 연관성을 분석하기 위한 기법이 카이제곱 검정(혹은 교차분석)이다. 따라서 카이제곱 검정을 사용하기 위해서는 ‘연령’등의 비율척도 변수를 ‘연령대’처럼 서열척도 변수로 변환하여 사용해야 한다. 카이제곱 검정의 기본 원리는 변수들 간의 범주를 동시에 교차하는 교차표를 만들어 각각의 빈도와 비율을 통해 변수 상호 간의 독립성과 관련성을 분석하는 것이다. 이는 수치로 나타내어지지 않으며 대신 검정 통계량 카이제곱(X^2)을 통해 변수 간에 연관성이 없다는 귀무가설을 기각하는지 여부로 상관성을 판단한다.

→ 우선 예시로 명목척도 변수 두 개의 교차표를 만들어 보겠다. 성별과 A제품 사용경험 유무로 이루어진 100개의 데이터를 남성이 사용해 본 경우, 사용해보지 않은 경우, 여성이 사용해 본 경우, 사용해보지 않은 경우로 나누어 관측 빈도를 계산했다.

→ 다음으로 두 변수가 독립적일 경우에 나타날 (4가지 경우에 대한) 기대빈도를 구한다. 기대빈도를 구하는 방식은 다음과 같다.

→ 위 예시의 수를 여기에 대입하면 다음과 같은 기대빈도를 구할 수 있다.

→ 이제 검정 통계량 카이 제곱(X^2)의 값을 구해 임계치와 비교하여 가설을 검정한다. 총 검정 통계량은 각 셀의 검정 통계량을 모두 계산해 더하며 가설검정은 (행의 수 - 1)(열의 수 - 1)을 통해 자유도를 구하여 임계치와 비교한다. 각 셀의 검정 통계량을 구하는 공식은 다음과 같다.

→ 각 셀의 검정 통계량을 모두 더한 값은 0.0873이고 해당 자유도의 유의수준 0.05 임계치는 3.84이므로 성별은 A 제품 사용 여부와 상관성이 없다는 귀무가설을 채택한다.

13-1. 선형 회귀분석과 Elastic Net(예측모델)

→ 회귀분석이라는 용어는 영국 인류학자 프랜시스 골턴이 부모의 키와 자식의 키에 대한 유전 법칙을 연구하다 시작되었다. 자식 세대의 키가 모집단의 평균으로 회귀한다는 ‘평균으로의 회귀’ 이론의 연구로 회귀분석은 시작되었으며 이후 칼 피어슨이 아버지와 아들 키 관계를 표현한 수식이 최초의 회귀식이 된다. 또한 X, Y 좌표에 산점도를 찍고 X와 Y의 관계를 가장 잘 나타낼 수 있는 직선을 찾음으로써 회귀분석 모델이 만들어졌다.

→ 회귀분석은 해당 객체가 소속된 집단의 X(독립변수) 평균값을 통해 Y(종속변수) 값을 예측하는 원리이다. 이때 집단을 세분화된 단위로 쪼개어 각 단위에서의 평균을 구하면 모든 단위의 집단에 대한 평균값을 통과하는 직선을 그릴 수 있다. 이때 오차를 최소화하여 그은 선이 바로 회귀선이다. 회귀분석을 한마디로 요약하면 ‘종속변수 Y의 값에 영향을 주는 독립변수 X들의 조건을 고려하여 구한 평균값’이라 할 수 있다.

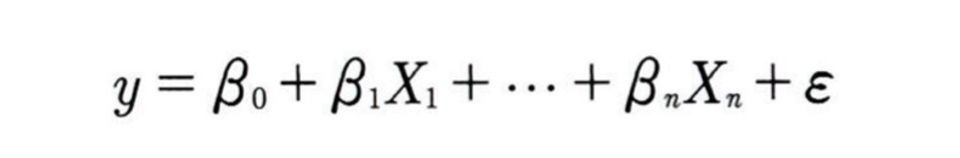

→ 회귀선은 절편, 기울기, 오차항으로 이루어진다. 오차항은 독립변수가 종속변수에 주는 영향력을 제외한 변화량을 뜻하며 회귀분석은 이 오차항을 최소화하는 절편과 기울기를 구하는 작업이다. 회귀선을 수식으로 표현하면 다음과 같다.

→ 위 수식에서 y는 예측하고자 하는 값이며 베타(0)는 절편, 베타(1~n)은 각 독립변수가 종속변수에 주는 영향력(계수) 값이고 X1~Xn은 각 독립변수이다. 마지막 값은 모델에 의해 설명되지 않는 잔차이다.

→ 최적의 회귀선을 구하는 작업을 모형 적합이라 부르며, 이는 회귀선과 각 관측치 포인트 간의 거리를 최소화하는 것이다. 구체적으로는 예측치와 관측치들 간의 수직 거리(오차)의 제곱합을 최소로 하는 직선을 찾게 된다(이러한 방법을 최소제곱추정법이라고 부른다).

→ 독립변수가 하나인 회귀분석은 단순 회귀분석 혹은 단변량 회귀분석이라 불리며 독립변수가 두개 이상이면 다중 회귀분석 혹은 다변량 회귀분석이라 불린다. 회귀분석을 하기 위해서는 독립변수 간에 상관관계가 없어야 하며(다중공선성이 없어야 하며) 그 외에도 다음과 같은 조건들을 필요로 한다(잔차 = 실제 관측값 - 예측값).

→ 선형 회귀는 독립변수와 종속변수가 비선형적 관계일 경우 예측력이 떨어진다. 이때는 변수를 구간화하여 이항변수로 표시된 몇 개의 더미변수로 변환해 분석을 진행하면 된다. 향수를 많이 뿌릴수록 매력도가 상승하지만 과도하게 많이 뿌렸을 때는 다시 매력도가 떨어진다고 했을 때, 구간화하여 더미변수로 변환하게 된다면 과도하게 많이 뿌린 구간에 대해서만 음의 관계를 갖도록 수식을 세울 수 있다. 또한 비선형성이 심하지 않은 경우에는 독립변수나 종속변수에 로그함수를 취하면 비선형성을 어느정도 완화시킬 수 있다.

<다항회귀>

→ 비선형적 관계를 일반 회귀모델로 담아내기에는 한계가 있다. 그렇기에 고안된 모델이 다항 회귀이다. 다항회귀는 독립변수와 종속변수의 관계가 비선형 관계일 때 변수에 각 특성의 제곱을 추가하여 회귀선을 비선형으로 반드는 모델이다. 다항회귀는 차수가 커질수록 편향은 감소하지만 변동성이 증가하여 분산이 늘고 과적합을 유발할 수 있다는 문제점이 있다.

→ 회귀분석에서는 기본적으로 모든 회귀계수가 0이라는 것을 귀무가설로 설정하며 적어도 하나의 변수는 회귀계수가 0이라는 것을 대립가설로 설정한다. 회귀분석을 수행했을 때 일반적으로 다음과 같은 변수별 결과 요약을 확인할 수 있다.

→ Parameter Estimate는 각 변수의 계수를 뜻하며(독립변수 X1이 1만큼 커질 때 종속변수 Y는 0.604만큼 증가한다) Intercept는 절편을 의미한다. Standard Error는 표준오차이며 이 값이 크다면 그만큼 예측값과 실젯값의 차이가 크다는 의미이다. 하지만 변수마다 스케일 단위가 다를 때는 표준오차의 절댓값만으로 실제 오차를 판단하기 어렵다. 이를 위해 사용하는 값이 T Value이다.

→ T Value(노이즈 대비 시그널의 강도)는 독립변수와 종속변수 간에 선형관계가 얼마나 강한지를 나타낸다. 이는 변수의 회귀계수 값을 표준오차로 나누어 구하며 절댓값의 크기로 변수의 유의성을 판단할 수 있다. 판단 기준은 관측치의 크기에 따라 달라지는데 관측치 100개 기준으로 T Value 값이 1.98을 넘으면 0.05 유의수준 임계치를 넘어서기 때문에 유의하다고 판단한다.

→ 관측치의 수와 각각의 T Value를 조합하여 유의도를 판단하는 것은 비효율적이기 때문에 P Value를 사용한다. P Value는 T Value와 관측치 수를 고려하여 한번에 유의도를 나타낸 값이다. 일반적으로 값이 0.05 이하일 때 95% 귀무가설 기각역에 포함하므로 유의하다고 판단하며, 경우에 따라 0.1이나 0.01을 기준으로 하기도 한다.

→ Tolerance(공차한계)와 VIF(분산팽창지수)는 다중공선성을 판단할 수 있는 값들이며 해당 변수의 다른 독립 변수들과 상관관계 수준을 판단하는 기준이다. 이 둘은 서로 역수 관계이다.

→ 위 도표에서 변수별 유의도와 공선성 통계량을 통해 모델이 최종적으로 사용할 변수를 선택할 수 있다. 하지만 선택된 변수들 조합에 따라 유의도와 공선성 통계량이 변하기 때문에 이는 생각보다 까다롭다. 우선 독립변수 X2와 X5의 VIF 값이 10을 훨씬 넘어가기 때문에 이들을 제거하려 하는데, X2만 제거했을 때와 X5만 제거했을 때의 다른 변수들의 유의도와 공선성 통계량, 모델 전체의 설명력 등을 각각 비교하여 최적의 조합을 찾아야 한다.

→ 이때 독립변수의 개수가 늘어난다면 수동으로 일일이 변수 조합을 테스트하는 것은 비효율적이다. 그렇기에 최적의 변수 조합을 선택하는 알고리즘을 사용하게 된다.

- 전진 선택법 : 절편만 있는 모델에서 시작하여 유의미한 독립변수 순으로 변수를 하나씩 추가하는 방법이다. 새로운 변수를 추가했을 때 모델 적합도가 기준치 이상 증가하지 못했을 때 변수선택이 종료되며 빠르다는 장점이 있지만 한번 선택된 변수를 제거하지난 않는다.

- 후진 제거법 : 모든 독립변수가 포함된 상태에서 시작하여 유의미하지 않는 변수 순으로 하나씩 제거하는 방법이다. 어느 한 변수를 제거했을 때 모델 적합도가 기준치 이상 감소한다면 변수선택을 종료한다. 독립변수가 많은 경우에는 학습 초기에 모든 변수를 사용하기 때문에 시간이 오래 걸릴 수 있지만 변수들을 모두 넣고 시작하기 때문에 전진 선택법보다는 안전한 방법이다.

- 단계적 선택법 : 처음에는 전진 선택법과 같이 변수를 하나씩 추가하다가 선택된 변수가 3개 이상이 되면 변수 추가와 제거를 번갈아 가며 수행한다. 단계적 선택법에서는 단순히 종속변수와 상관도가 높은 독립변수를 선택하는 것이 아니라, 선택된 독립변수들로 이루어진 모델의 잔차를 구하여 이와 상관도가 높은 잔차를 가진 변수를 선택한다. 가장 최적의 변수 조합을 찾아낼 수 있는 가능성이 높지만 많은 조합을 비교하기 때문에 시간이 오래 소요된다.

→ 이외에도 단계적 선택법 알고리즘을 개선한 LARS, 변수 조합에 약간의 우연적 요소를 가미하는 유전 알고리즘 등이 있다. 하지만 최근에는 Ridge와 Lasso를 조합한 Elastic Net이 주로 사용된다.

< Ridge와 Lasso, 그리고 Elastic Net >

→ Ridge와 Lasso는 변수 계수에 가중치를 주어 예측 정밀도를 높이는 기법이다. 우선 Ridge(혹은 L2 - norm)는 전체 변수를 모두 유지하면서 각 변수의 계수 크기를 조정한다. 종속변수 예측에 영향을 거의 미치지 않는 변수에는 0에 가까운 가중치를 주어 다중공선성을 방지하면서 모델의 설명력을 최대화할 수 있다. 이러한 조정을 계수 정규화라고 한다. Ridge에서는 매개변수 alpha 값을 통해 정규화 수준을 조정한다. alpha값이 0이면 선형회귀와 동일해지고 값이 커질수록 독립변수들의 영향력이 작아져 회귀선이 평균을 지나는 수평선에 가까워진다.

→ Lasso(혹은 L1 - norm)는 Ridge와 유사하지만 중요한 몇 개의 변수 이외의 변수들에는 계수를 0으로 주어 변수의 영향력을 아예 없앤다. Ridge처럼 alpha값을 통해 정규화의 강도를 조절하며 영향력이 작은 변수를 모델에서 삭제하기 때문에 모델이 단순해지고 해석이 용이하다.

→ Elastic Net은 Ridge와 Lasso를 결합한 모델이다. Ridge에서는 변환된 계수가 0이 될 수 없지만 Lasso에서는 0이 될 수 있다는 특성을 결합했으며 둘 사이의 혼합비율(r)을 조절하여 최적의 성능을 끌어낼 수 있다. 혼합비율(r)이 0에 가까울수록 Ridge와 같아지며 1에 가까울수록 Lasso와 같아지게 된다. 독립변수들이 이미 잘 정제되어 중요할 것으로 판단되는 변수들로 이루어져 있다면 Ridge 비율을 높이는 것이 좋고 변수 선택 없이 주어진 변수들을 모두 집어넣은 상태라면 Lasso 비율을 높이는 것이 좋다.

→ 마지막으로 회귀분석 모델을 평가하는 방법에 대해 알아보겠다. 회귀분석 모델에서는 다음과 같은 결괏값들을 확인할 수 있다.

→ 위 결과 표에서 1번은 모델에 대한 유의도, 2번은 모델 설명력, 3번은 수정된 모델 설명력이며 해당 세 결괏값이 중요한 부분이다. 모델에 대한 유의도가 0.05보다 작기 때문에 적어도 한개 이상의 독립변수는 종속변수에 대한 선형 회귀 모형이 존재한다고 판단할 수 있다. 2번의 결정계수(설명력)는 선택된 독립변수들로 종속변수를 얼마나 설명할 수 있는지를 나타내며 0.773의 값은 종속변수를 77.3% 설명한다는 것을 의미한다. 3번 값은 유의도가 낮더라도 독립변수가 많을수록 다중 회귀분석에서 결정계수 값이 커지는 특성을 상쇄하기 위해 사용한다. 이는 기존의 결정계수 값을 변수의 개수로 나눈 것이며 특히 사용된 변수가 많을 때 3번 값을 함께 보고 모델의 설명력을 판단해야 한다.

→ P value와 R - Square 값이 어떤가에 따라 회귀 모델 튜닝 방법은 다음과 같이 달라진다.

13-2. 로지스틱 회귀분석(분류 모델)

→ 로지스틱 회귀분석은 종속변수가 (양적척도가 아닌) 질적척도인 분류 모델이다. 기본 모형은 종속변수가 0과 1인 이항 분류이며 종속변수의 범주가 3개 이상인 경우에는 다항 로지스틱 회귀분석을 사용한다.

→ 로지스틱 회귀분석에서는 기존 선형회귀식을 그대로 사용하되 종속변수를 1이 될 확률로 변환하여 그 확률에 따라 0과 1로 분류한다. 우선 오즈(Odds)와 로짓 변환에 대해 알아보겠다.

→ 위 그래프는 각각 선형 회귀선과 로짓 회귀선이다. 종속변수가 0과 1일 때 선형 회귀선에서는 확률이 양과 음의 무한대로 뻗어 나가버린다. 이를 해결하기 위해 로짓 회귀선과 같이 0~1 범위의 S자 곡선을 사용해야 한다. 이때 종속변수의 값을 1이 될 확률이라 정의하고 값이 0.5보다 크면 1, 작으면 0으로 분류하는 것이다.

→ 로짓 회귀선으로 변환해주기 위해 우선 오즈 값을 구해야 한다. 오즈란 사건이 발생할 가능성이 발생하지 않을 가능성보다 어느정도 큰지 나타내는 값이다. 즉 분모는 사건이 발생하지 않을 확률, 분자는 사건이 발생할 확률이 된다. 다음과 같이 정리할 수 있다.

→ 직선 형태의 회귀 값을 사건이 일어날 오즈 값으로 변환하게 되면 분류 모델에 가까워진 듯한 느낌이 든다. 하지만 위 수식에는 발생 확률이 0에 가까워지면 오즈 값은 0이 되지만 발생 확률이 1에 가까워질수록 오즈값이 무한대로 치솟는 문제점이 존재한다. 또한 오즈 값에 로그를 취하더라도 양의 무한대에서 음의 무한대의 범위를 가져 0~1 사이의 값으로 나타내지 못하게 된다.

→ 확률을 0과 1 사이의 값으로 나타내기 위해 확률을 로짓 변환해 준다. 이때 사용되는 변환식이 시그모이드 함수이다. 로그를 취한 오즈에 시그모이드 함수를 적용한 최종 로지스틱 회귀식은 다음과 같다.

→ 로지스틱 회귀에서 카테고리를 분류하는 기본적인 기준값은 0.5이지만 실제로는 어떤 주제의 모델인가에 따라 최적의 효율을 따져가며 분류 기준을 잡아야 한다.

→ 다항 로지스틱 회귀분석에서도 각 범주마다 이항 로지스틱을 시행하여 확률을 구한다. 이때 종속변수의 모든 범주에 해당하는 확률의 합은 100%가 되어야 한다. 그리고 범주들 간에 확률이 어느 것이 더 큰지를 알아야 하기 때문에 하나의 범주를 기준으로 잡아 나머지 범주들과 비교하여 식을 만든다.

→ 이때 1에서 세 범주의 확률을 뺀 값이 p(D)가 되기 때문에 다항 로지스틱 회귀분석은 이항 로지스틱 식이 K - 1개가 필요하다.

→ 일반 이항 로지스틱 회귀분석의 결과 모형은 선형 회귀분석과 유사하게 나온다. 우선 각 변수에 대한 계숫값과 유의도가 나오며 모든 변수의 값과 계숫값으로 결괏값을 계산해 로지스틱 회귀식에 대입해 주면 예측 확률을 구할 수 있다.

→ 로지스틱 회귀분석에서는 추가적으로 각 변수의 오즈 비를 알 수 있다. 독립변수 X1이 1이 커질 때마다(혹은 더미변수라면 X1의 값이 1일 때, 0일 때보다) 종속변수가 1일 확률이 1.223배 증가한다는 것이다.

→ 로지스틱 회귀분석에서도 결정계수(R^2) 값이 산출되는데, 선형회귀처럼 연속형 값에 대한 분산이 존재하지는 않으므로 다른 방식으로 결정계수 값을 구하게 된다. 이때 결정계수 값을 구하는 방법은 공식적으로도 10가지가 넘으며 딱히 대표적인 방법이 없다. 그중 하나인, 슐이 제안한 식별계수 방법으로는 종속변수의 발생(1)과 미발생(0)으로 나누어 각각 예측 확률의 평균값을 구한 뒤 그 차이를 계산한다. 모델이 예측을 명확하게 한다면 발생과 미발생의 확률은 확연히 다를 것이다.

'데이터 분석가가 반드시 알아야할 모든 것' 카테고리의 다른 글

| 서포트벡터머신, 연관규칙과 협업 필터링 (0) | 2024.05.01 |

|---|---|

| 모델 평가 (0) | 2024.04.10 |

| 데이터 분석하기2 (1) | 2024.04.03 |

| 데이터 전처리와 파생변수 생성 (0) | 2024.03.20 |

| 데이터 탐색과 시각화 (0) | 2024.03.13 |