1.1 데이터를 분석하다

<데이터 분석의 목적> → 목적에 따라 데이터 획득/분석 방법이 달라짐

1. 데이터 요약 :

raw data로는 데이터의 경향을 알기 어려움 → 평균값 등을 통해 데이터를 요약, 정리 필요

2. 대상 설명 :

"대상이 가진 성질과 관계성을 명확히 밝히고 이를 이해한다"

<모든 가능성 배제>

실험군 : 실험에서 효과가 기대되는 처리를 한 집단

대조군 / 통제군 : 비교, 대조하기 위한 집단

단일맹검법 : 피험자에게 안다면 편견 등으로 결과에 영향을 줄 정보를 알리지 않고 실험하는 방법

이중맹검법 : 연구자가 무의식적으로 피험자에게 영향을 줄 가능성을 배제하고자 연구자도 정보(약 종류)를 모른 채 실험하는 방법

→ 모든 가능성을 배제하고 남아있는 것만 확고한 증거가 됨

인과관계 : 2가지 중 하나(원인)를 변화시키면, 다른 하나(결과)도 바꿀 수 있는 관계

→ 인과관계를 아는 것은 곧 원리(매커니즘)에 관한 지식을 얻는 것이므로 깊은 이해

→ 원인을 바꿈(개입)으로써 원하는 결과를 얻을 수 있음

→ ex) 신약과 혈압

상관관계 : 한쪽이 크면 다른 한쪽도 큰(또는 한쪽이 크면 다른 한쪽은 작은) 관계

→ 한쪽을 변화시켰다 하더라도 다른 한쪽이 변한다고 단정할 수 있다는 점에서 인과관계와 다름

→ 원리에 관련된 몇 가지 가능성을 구별할 수 없으므로 얕은 이해

→ ex) 연소득과 행복도 : 좋은 가정환경에서 자랐다는 사실이 소득과 행복도 양쪽에 영향을 줬을 가능성 등 구별 불가

→ 상관관계가 있다면 미지의 데이터 예측이 가능해짐

3. 미지의 데이터 예측 :

이미 얻은 데이터를 기반으로, 이후 새롭게 얻을 데이터를 예측하는 것

- 두 요소 간의 선형관계 예측 값과 실제 값에는 차이가 생기기 마련이지만, 통계분석을 통해 예측이 들어맞기 쉬운 관계성을 발견할 수 있으며 차이가 어느 정도인지 평가하는 것도 중요함

f. 기계학습 : 해석이 어려운 복잡한 관계를 추출하고 예측

1.2 통계학의 역할

: 퍼짐(산포, dispersion)이 있는 데이터에 대해 설명이나 예측하는 것

퍼짐 : 데이터에 포함된 값 하나하나의 차이 → 불확실성

→ 데이터 퍼짐이나 불확실성을 확률로 나타내는 확률론 사용

1.3 통계학의 전체 모습

기술통계(descriptive statistics) : 수집한 데이터를 정리하고 요약하는 방법

→ 데이터 자체의 특성이나 경향을 알 수 있음

→ 확보한 데이터에만 집중

추론통계(inferential statistics) : 수집한 데이터로부터 데이터의 발생원을 추정하는 방법

→ 크게 통계적 추론과 가설검정이 있음

통계적 추론(statistical inference) : 데이터에서 가정한 확률 모형의 성질을 추정하는 방법

→ ex) 모서리가 닳은 주사위의 확률이 1/6이 아닐지도 모르니 통계적 추론을 이용해 얻은 데이터로 부터 각 눈이 어떤 확률로 나오는 주사위인가를 추정

가설검정(statistical test) : 세운 가설과 얻은 데이터가 얼마나 들어맞는지를 평가하여, 가설을 채택할 것인가를 판단하는 방법

→ ex) 모서리가 닳더라도 각 눈이 똑같은 1/6 확률로 나온다는 가설을 세우고 데이터를 얻어보니 1의 눈에 치우쳤으면 가설이 잘못되었다고 판단

데이터 유형이나 변수(특정 속성의 데이터)의 개수, 가정하는 확률 모형 등에 따라 이용하는 통계분석 방법이 다름

2.1 데이터 분석의 목적과 알고자 하는 대상

데이터 분석을 시작할 때:

1. 데이터 분석의 목적 정하기

→ ex) 신약의 효과 알아내기

2. 알고자 하는 대상 명확히 하기

→ ex) 고혈압이 있는 "모든" 사람(의 혈압)

2.2 모집단

모집단 : 알고자 하는 대상 전체

→ ex) 신약 복용자가 포함된 모집단, 위약 복용자가 포함된 모집단, 주사위를 무한하게 던졌을 때 나오는 눈의 전체 집합

→ 데이터 분석 목적과 알고자 하는 대상에 기초하여 직접 모집단을 설정해야 함

→ 실제로 데이터를 얻을 가능성이 없는 요소를 제외하여 모집단을 설정해야 함 (분석의 일반화와 관련된 중요한 지점!)

모집단 크기 : 모집단에 포함된 요소(element)의 수

→ 크기에 따라 유한모집단과 무한모집단으로 나눌 수 있음

유한모집단 : 모집단 중 한정된 요소만 포함한 것

→ 원칙적으로는 모든 요소를 조사하는 것이 가능하지만, 시간과 비용이 많이 들기 때문에 현실적이지 않음

→ ex) 1반 2반 학생, 한국인

무한모집단 : 모집단 중 포함된 요소의 개수가 무한한 것

→ 요소 전부를 조사한다는 것은 불가능함

→ ex) 신약 효과의 예에서는 미래에 고혈압으로 약을 복용할 사람도 대상에 포함되기 때문에 제한 없음, 주사위

2.3 모집단의 성질을 알다

모집단의 성질 : 모집단에 포함된 요소를 특징 짓는 값

→ 모집단의 성질을 알 수 있다면 대상을 설명하거나 이해할 수 있고, 미지의 데이터를 예측할 수 있음

→ ex) 한국인 남성의 평균 키는 172.5cm이다.

전수조사 : 모집단에 포함된 모든 요소를 조사하는 것

→ 유한모집단일 때 선택할 수 있는 조사 방법

→ 분석할 데이터 = 모집단

→ 데이터 그 자체의 특징을 기술하고 요약하는 기술통계(descriptive statistics)

-) 비용이나 시간 면에서 부담이 큼

-) 무한모집단은 불가능

표본(sample) : 추론통계에서 조사하는 모집단의 일부(유한한 개수의 요소)

표본추출(sampling) : 모집단에서 표본을 뽑는 것

표본조사 : 표본을 이용해 모집단의 성질을 조사하는 것

→ 어느정도 불확실성을 염두에 두고 평가

표본크기(sample size) : 표본에 포함된 요소의 개수 (n)

→ 모집단의 성질을 추정할 때의 확실성이나 가설검정의 결과에도 영향을 미침

→ ex) n=30

3.1 데이터 유형

변수 : 데이터 중 공통의 측정 방법으로 얻은 같은 성질의 값

→ 각각 다른 값을 취할 수 있음

→ ex) 키 - 1변수 데이터 - 1차원, 키와 몸무게 - 2변수 데이터 - 2차원

→ 변수가 여러 개인 경우, 변수 간의 관계를 밝히고자 데이터를 분석할 수 있음

→ 변수의 개수를 차원으로 표현하기도 함

고차원 데이터 : 여러 개의 변수를 포함한 데이터

변수의 유형마다 분석 방법이 달라짐 -> 데이터를 수집할 때나 분석을 실행할 때 변수가 어떤 유형인지 고려해야 함

양적 변수 (수치형 변수) : 숫자로 나타낼 수 있는 변수

→ 숫자이므로 대소 관계가 있으며, 평균값처럼 양을 계산할 수 있음

→ 이산형과 연속형으로 나눌 수 있음

이산형 양적 변수 (이산변수) : 얻을 수 있는 값이 점점이 있는 변수

→ ex) 주사위 눈, 횟수, 사람수 등 셀 수 있는 숫자 데이터

연속형 양적 변수 (연속변수) : 간격 없이 이어지는 값으로 나타낼 수 있는 변수

→ ex) 키, 몸무게

질적 변수 (범주형 변수) : 숫자가 아닌 범주로 나타내는 변수

→ 대소 관계 없으며, 평균값 등의 수치도 정의할 수 없음

→ ex) 설문조사의 예/아니요, 식당 메뉴

3.2 데이터 분포

원자료를 바라본다고 해서 전체 경향을 파악하거나 대상을 설명하고 이해할 수 없기 때문에, 데이터가 어떻게 분포되어 있는지를 그래프 등으로 시각화하여, 대략적인 데이터 경향을 파악하는 것이 데이터 분석의 첫 단계!

어떤 값이 데이터에 몇 개 포함되어 있는가(도수, 빈도, 횟수)를 나타내는 그래프인 도수 분포도(히스토그램) 자주 사용

이산형 양적 변수의 히스토그램 : 가로축은 숫자, 세로축은 데이터에 나타낸 개수(도수, 빈도, 횟수) 표시

연속형 양적 변수의 히스토그램 : 범위(구간폭, bin width)를 설정하고, 그 범위에 포함되는 숫자 개수를 세어 세로축에 둠

→ 소수점 이하 자리가 얼마든지 지속되기 때문에 엄밀하게 같은 값은 존재하지 않음 (측정 기구의 정밀도 차이)

→ 구간폭 설정에 따라 인상이 달라짐

(그림 3.2.2) 스터지스 공식 등 적절한 구간폭을 결정하는 공식이 있지만 올바른 구간폭이란 건 존재하지는 않음

범주형 변수의 히스토그램 : 가로축에 각 범주, 세로축에 각 범주에 속하는 개수 표시

히스토그램은 대략적인 데이터 구성을 파악하는 목적일 뿐, 결론을 내리기 위한 것이 아님!

3.3 통계량

통계량 : 수집한 데이터로 이런저런 계산을 수행하여 얻은 값

데이터 분석 : 다양한 통계량 계산을 통해 이해하는 과정

기술통계량 / 요약통계량 : 데이터 그 자체의 성질을 기술하고 요약하는 통계량

→ 주로 양적 변수를 대상으로 계산, 범주형 변수의 경우 개수, 비율로만 가능

<대표적인 기술통계량>

대략적인 분포 위치를 나타내는 대푯값 : 평균값, 중앙값, 최빈값

데이터 퍼짐 정도를 나타내는 값 : 분산, 표준편차

대푯값(representative value) : 대략적인 분포 위치, 즉 대표적인 값을 정량화하기 위해 사용하는 통계량

→ 데이터가 어디를 중심으로 분포하는지의 정보를 얻을 수 있음

평균값(mean)

→ 표본의 평균값은 표본평균

중앙값(median) : 크기 순으로 값을 정렬했을 때 한가운데 위치한 값

→ 가운데에 있는 값이 2개면, 두 값의 평균값

→ 순서에만 주목하기 때문에, 극단적으로 크거나 작은 값에 영향을 받지 않음

최빈값(mode) : 데이터 중 가장 자주 나타나는 값

-> 전체에서 어느 값이 전형적으로 나타나는가를 파악할 때 도움이 됨

이상값(outlier) : 극단적으로 크거나 작은 값

→ 평균값은 쉽게 영향을 받으나 중앙값, 최빈값은 영향을 많이 받지 않음

데이터 퍼짐을 평가하기 위해서 분산(variance) 또는 표준편차(standard deviation, S.D.)로 계산

→ 표본에서 구하고, 표본을 평가한다는 점을 강조해 표본분산, 표본표준편차라고 부르기도 함

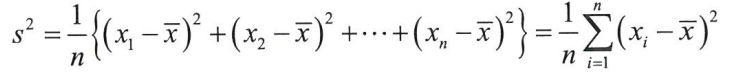

표본분산(s2): 표본의 각 값과 표본평균이 어느 정도 떨어져 있는지를 평가하는 것으로, 데이터 퍼짐 상태를 정량화한 통계량

→ s2 ≥ 0

→ 모든 값이 같다면 0

→ 클수록 데이터 퍼짐 정도가 크다는 의미

표본표준편차(s) : 표본분산의 제곱근

→ 표본분산과 포함하는 정보에는 차이 X

→ 제곱근을 취하므로 원래 단위와 일치

<분포를 시각화하는 다양한 방법>

상자 수염 그림(box-and-whisker plot)

→ 상자와 수염이 각각 데이터의 분포를 특징 짓는 통계량을 나타냄

→ 중앙값, 사분위수, 최댓값, 최솟값 등의 통계량은 나타내지만, 히스토그램과 같은 상세한 분포 형태는 포함하지 않음

→ 상자 - 제1사분위수부터 제3사분위수까지의 범위

막대그래프 + 오차 막대 : 평균값을 막대그래프의 높이로 나타내고, 표준편차(S.D.)를 평균값 아래위로 늘린 오차막대로 표시한 그림

→ 평균값과 표준편차 2가지 통계량을 시각화한 것으로, 분포 형태까지는 자세히 알 수 없음

→ 추론통계에서 S.D.가 아닌 표준오차(standard error, S.E.)를 오차 막대로 그리는 경우가 많으므로, 오차 막대가 무엇을 나타내는지 범례로 작성해야 함

바이올린 플롯(violin plot) : 히스토그램을 부드럽게 표현한 그래프로, 어디쯤 데이터가 존재하기 쉬운지를 추정해 나타냄

스웜 플롯(swarm plot) : 값이 겹치지 않도록 점을 찍음으로써, 각 데이터가 어디에 있는지 자세하게 나타냄

→ 통계량은 표시되지 않지만, 분포 형태나 자세한 데이터 위치 정보가 시각화되어 있음

보통 평균값에서 표준편차의 2배 또는 3배 이상 벗어난 숫자를 이상값으로 봄

→ 이상값이 실제 값인지 측정 실수나 데이터 기록 실수인지 판단해야 함

3.4 확률

확률 : (발생 여부가) 불확실한 사건의 발생 가능성을 숫자로 표현한 것

사건 A의 확률 : 0 ≤ P(A) ≤ 1

경우의 수로부터 확률을 정의하려면 모두 동등한 확률로 꺼내진다는 가정이 필요. 현대 확률론은 사건에 실수를 할당하여 확률을 정의하는 측도론적 사고에 기반을 두고 있음

(* 측도 : 집합에 크기를 부여하고 계산하는 함수 )

→ 측도론을 이용한 확률론에서는 확률변수 X를 사건을 나타내는 집합의 요소를 실수로 변환하는 함수로 정의

확률변수 : 확률이 달라지는 변수 | P(X=a) 의 X

→ 범주나 서로 떨어진 값 : 이산형 확률변수 , 연속한 값 : 연속형 확률변수

실현값 : 확률변수가 실제로 취하는 값 | P(X=a) 의 a

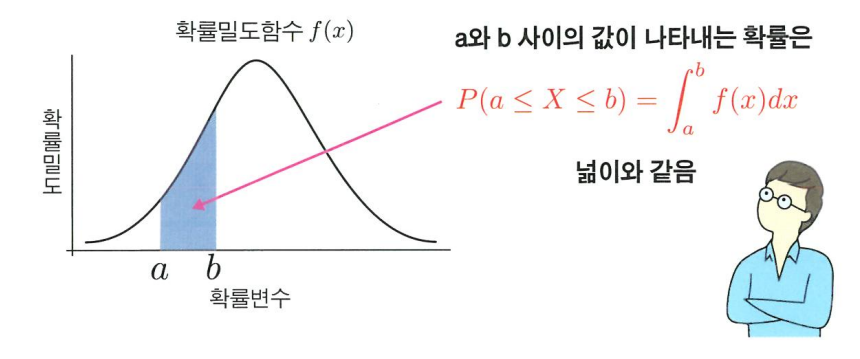

확률분포 : 가로축에 확률변수, 세로축에 확률변수의 발생 가능성을 표시한 분포

정의역 전체 적분 = 1

추론통계 → 모집단의 일부인 표본에서 모집단의 성질을 추정 but 어려움

→ 현실 세계의 모집단을 수학 세계의 확률분포로 가정하고, 표본 데이터를 그 확률분포에서 생성된 실현값인 것으로 가정하여 분석 진행

→ 모집단과 표본 데이터처럼 다루기 어려운 대상이 확률분포와 그 실현값처럼 다룰 수 있는 대상으로 치환됨

→ 표본을 이용해 확률분포를 특징 짓는 숫자를 추정함으로써 모집단을 이해하고자 함

통계적 추론 : 얻은 데이터로부터 그 발생원이 어떤 확률분포를 취하는지를 추정하는 것

양적 확률변수라면, 확률분포를 특징 짓는 양 계산 가능

기댓값 ( E(X), 평균 ) : 변수가 확률적으로 얼마나 발생하기 쉬운가를 평균적인 값으로 나타낸 값

이산형

k : 확률변수가 가질 수 있는 실현값의 개수

각 실현값과 그 값이 발생할 확률을 곱하여 더함

연속형

실현값 x와 그에 대응하는 확률밀도 f(x)를 곱한 후, 적분한 값 (적분 범위 : 확률변수가 정의된 전 범위)

분산 ( V(X) ) : 확률분포가 기댓값 주변에 어느 정도 퍼져있는지 나타내는 값

각각 기댓값과의 차이를 제곱한 숫자를 이용해 계산

표준편차 : 분산 V(X)의 제곱근을 취한 값

<분산, 표준편차의 성질>

- 0 이상

- 모두 같은 값이 나타나는 경우엔 0

- 기댓값에서 떨어진 값이 많을수록 커짐

왜도 (skewness) : 분포가 좌우대칭에서 어느 정도 벗어났는지로 평가

첨도 (kurtosis) : 분포가 얼마나 뾰족한지와 그래프의 꼬리가 차지하는 비율(분포의 양쪽 끝 꼬리의 확률 크기)이 얼마인지로 평가

<확률변수가 2개일 때>

동시확률분포 ( P(X,Y) ) : 확률변수 2개를 동시에 생각할 때의 확률분포

독립 : P(X,Y) = P(X) x P(Y)

→ 한쪽이 어떤 값을 취하든지, 다른 한쪽의 발생 확률은 변하지 않음

조건부확률 ( P(X|Y) ) : 한쪽 확률변수 Y의 정보가 주어졌을 때, 다른 한쪽 확률변수 X의 확률

→ X : 확률변수 , Y : 조건

독립 : P(X|Y) = P(X)

3.5 이론적인 확률분포

: 수식으로 표현되며, 분포의 형태를 정하는 숫자인 파라미터(parameter, 모수)를 가짐

→ 파라미터를 알면 확률분포의 형태를 알 수 있음

정규분포 / 가우스 분포 (normal distribution / Gaussian distribution)

→ 평균 μ와 표준편차 σ 2개의 파라미터로 정해짐 ( μ: 분포 위치, σ: 분포 넓이 )

→ N(μ, σ^2)로 표기

→ μ=0, σ=1인 정규분포 N(0,1)를 표준정규분포라 함

<정규분포의 특징 / 성질>

→ 평균 μ를 중심으로 한 종형으로, 좌우대칭 분포

→ 평균 μ 근처에 값이 가장 많고, 평균 μ에서 멀어질수록 적어짐

→ μ - σ부터 μ + σ까지의 범위에 값이 있을 확률 = 약 68%

→ μ - 2σ부터 μ + 2σ까지의 범위에 값이 있을 확률 = 약 95%

→ μ - 3σ부터 μ + 3σ까지의 범위에 값이 있을 확률 = 약 99.7%

표준화 (standardizing, normalizing) : 확률변수 x, 데이터의 평균 μ(x̅)와 표준편차 σ(s)를 이용하여 평균 0, 표준편차 1로 변환하는 것

→ 변환된 새로운 값 : z 값

→ 본래 점수 자체가 아닌 분포 안에서의 위치로 평가할 수 있게 됨